例行汇报:2025/10/28

进度报告 2025/10/28

1 基础知识

1.1 Transformer

Transformer 是一种 Sequence to Sequence (Seq2Seq)模型,表示输出长度不固定,有很多任务使用 Transformer 模型进行处理,包括:

- QA任务:指的是通过给出 Question,让网络输出 Answer 的任务(绝大多数任务都可以使用 QA形式)

- Multi-lable Classificaion:某一个物品可以有多个标签,类似于不定项选择

- Object Detection:目标检测功能

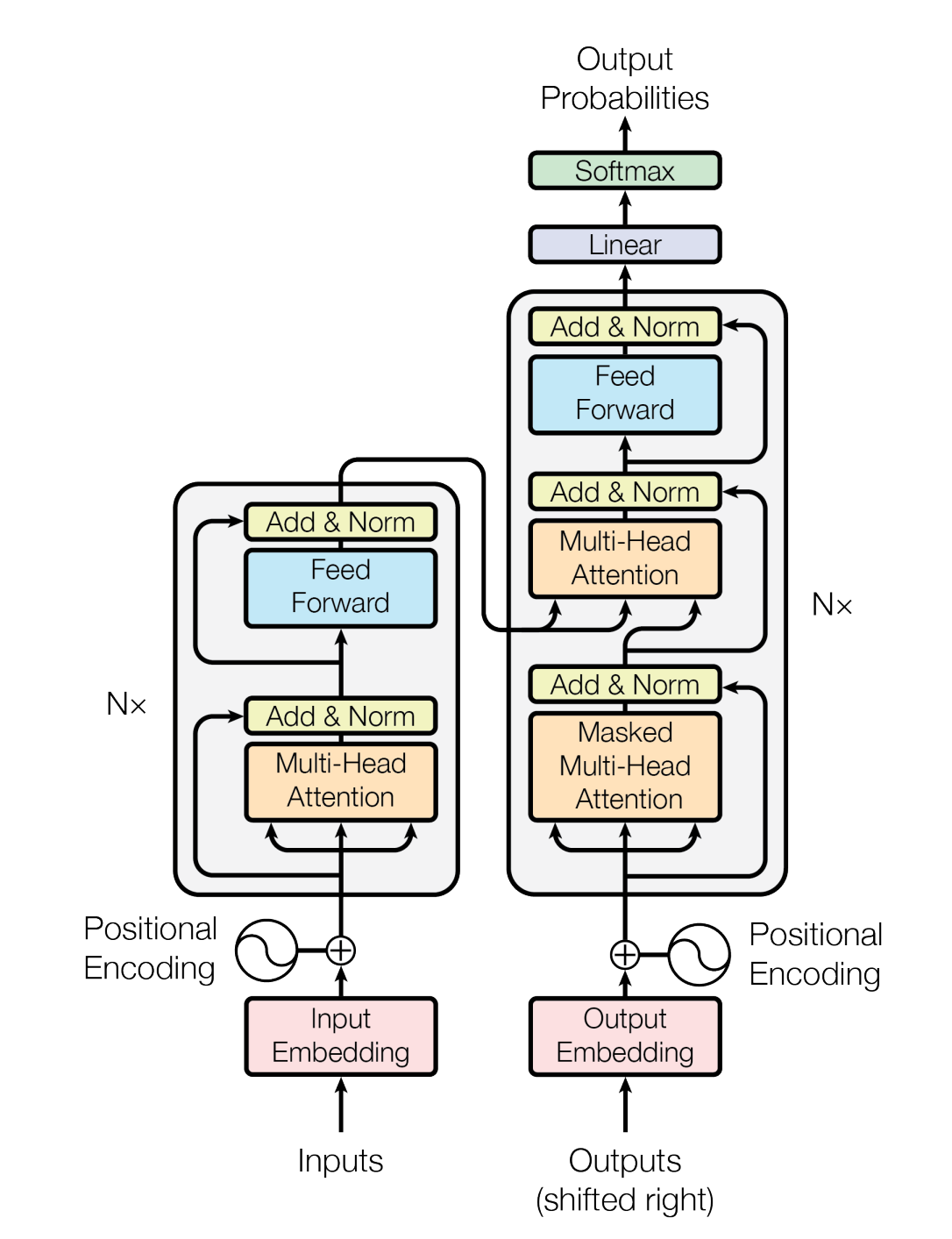

网络模型总览,可以发现 Encoder 和 Decoder 有功能重叠的模块

1.1.1 Encoder

Transformer 的 Encoder 实际上包含了一部分 Self-attention 架构,额外添加了一部分新的模块:Residual 模块将原输入和 Self-attention 的结果相加;Norm 模块将数值进行归一化。在进入全连接层之后,同样进行了一次 Residual 和 Norm

1.1.2 Decoder

这里以 Autoreressive Decoder 为例

Decoder 实际上的运作模式是,将上一个输出作为输入传递进去(类似于马尔可夫链),需要指定一个起始和结束 token ,在输入后模型计算最大概率的输出,如果模型认为这一次输出结束,则会结束 token 概率会达到最大。

其中的用到的是 Masked Self-attention (因为按照顺序输入,之前的数据是拿不到后续的数据的,mask 就是在之前部分将后续部分掩盖,不加入计算)

实际上还有一种 Non-Autoregressive 模式(简称 NAT),是一次性并行输入所有的 begin token

NAT 使用另一个长度的预测器来决定输出长度,或者忽略 End token 后文的所有内容

NAT 相对于 AT 的优点在于可以并行计算,同时其长度是可控的,但是其表现是低于 AT 的, 参见多模态内容(Multimodality)

1.1.3 Cross-attenstion

将 masked self-attention 的输出 q 结合到 Encoder 的输出中,形成交叉

1.1.4 训练方式

Transformer 的训练方式实际上和分类问题很相似,就是让输出和正确答案之间的 Cross Entropy 最小

给 Decoder 每一次的 token 输入正确答案,检查下一个是否正确

Validation 使用的是将完整的句子和输出结果进行比较,称为 BLEU Score(与 Train 的目标不相同),导致 Mismatch (exposure bias) ,一种解决方法是使用强化学习(Reinforcement Learning),通过给 Decoder 加入错误的输入,来进行训练,在 Transformer 中称为 Scheduled Sampling

1.2 各种各样的 Self-attention

Self-attention 处理的是输入为 Sequence 的情况,其问题在于 Attention Matrix 的计算量过于庞大,输入为 N对应的矩阵的大小为 N*N

下面列出一些 Self-attention 的变体:

- Local Attention, Truncated Attention:只考虑相邻数据,约等于 CNN

- Stride Attention:跳格子计算

- Global Attention:只挑选指定的 token 做全局的 attention,其他普通的 token 只和特殊 token 计算

- Longforer, BigBird:将 123 方法全部应用

- Clustering, Reformer, Routing TransformerL:只有在 query 和 key 在同一个 cluster 才会计算

- Sinkhorm Sorting Network:跳出人为指定框架,使用 Data-driven

- Linformer, Compressed Attention:缩小 attention matix 的计算量(通过交换矩阵点乘来降低运算复杂度)

- Efficient Attention:将 attention weight 作为参数计算

- ...

详细的内容可以参考论文 Long Range Arena: A Benchmark for Efficient Transformers,论文链接

2 文献查找

本周开始视频编码入门项目,查找了一些 IF 相对较高的 Review 文献

- Deep learning-based video coding: A Review and a case study: ACM Computing Surveys: Vol 53, no 1. (n.d.). https://dl.acm.org/doi/10.1145/3368405

- Sikora, T. (2005). Trends and perspectives in image and video coding. Proceedings of the IEEE, 93(1), 6–17. https://doi.org/10.1109/jproc.2004.839601 (2005年,较为古早)

- Ding, D., Ma, Z., Chen, D., Chen, Q., Liu, Z., & Zhu, F. (2021). Advances in video compression system using Deep Neural Network: A review and case studies. Proceedings of the IEEE, 109(9), 1494–1520. https://doi.org/10.1109/jproc.2021.3059994 (Dandan Ding 老师)

- Ma, S., Zhang, X., Jia, C., Zhao, Z., Wang, S., & Wang, S. (2020). Image and Video Compression With Neural Networks: A Review. IEEE Transactions on Circuits and Systems for Video Technology, 30(6), 1683–1698. https://ieeexplore.ieee.org/abstract/document/8693636

3 Deep Learning-Based Video Coding: A Review and a Case Study

注意:该文献发表于 2020 年

此处不进行详细的内容介绍,仅仅概述主要内容

该文献是一篇文献综述,主要总结了结合深度学习的视频编码、视频压缩相关内容。

3.1 图像编码基础

无损压缩的效率过低,一般使用有损压缩,常用 均方误差(MSE) 来评估原始图像与重建图像之间的差异

$$ \mathrm{MSE} = \frac{\|\mathbf{x} - \mathbf{x}_{\mathrm{rec}}\|^2}{m \times n} $$

相应的,重建图像相较于原始图像的质量可通过峰值信噪比(PSNR)

$$ \mathrm{PSNR} = 10 \times \log_{10} \left( \frac{(\max(\mathbb{D}))^2}{\mathrm{MSE}} \right) $$

3.2 深度网络方案

- 像素概率建模:根据香农信息论,求解像素概率以最大可能逼近极限值,常用方法包括逐行扫描,使用先前的像素进行预测。利用深度学习擅长预测的优势,进行像素概率建模

- 自编码器:将输入的高维用低维编码,然后解码部分再恢复高维,该方法自动学习,不需要人工进行特征标注。这个方法的问题是量化的过程是不可微分的,因而训练有一些难度,一般采用变化编码(Transform coding)

- 混合图像编码:两者相结合,预测编码可以实现更高的压缩比,变换编码有利于并行解码

- 视频编码:使用帧间预测来消除多图像之间冗余部分,深度网络可以用于像素级运动估计(光流估计)和运动补偿

- 专用编码:关注 感知自然度(perceptual naturalness)和语义质量(semantic quality),针对这两类指标制定的视频编码

3.3 深度网络工具

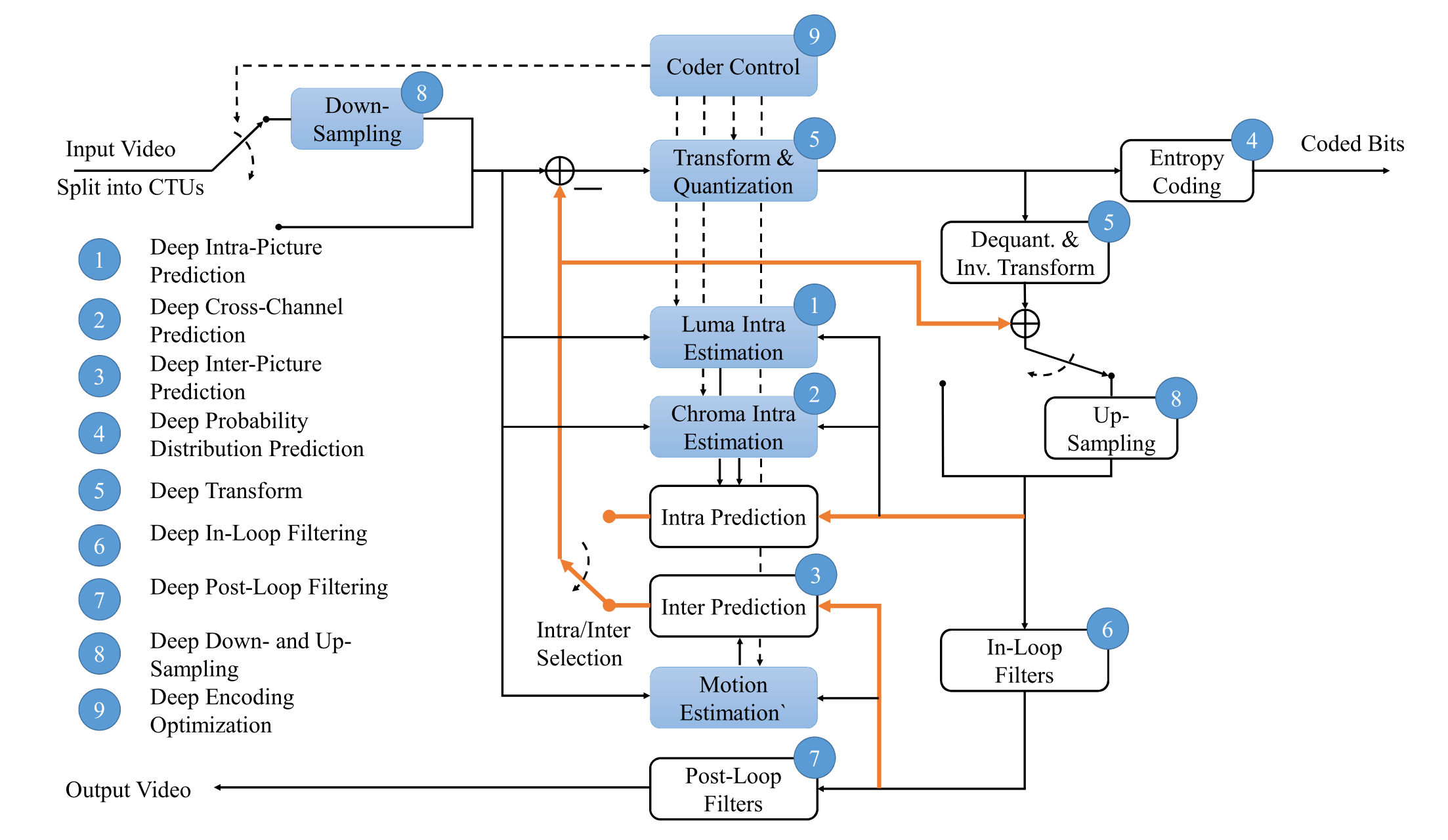

常见的处理流程(参见上图):将图划分为块,块被划分成通道(YUV),已压缩部分可用于预测后续部分,包括帧内预测(块间)、跨通道预测(通道间)和帧间预测(图像间)。预测残差随后经过变换、量化和熵编码以生成最终比特由于量化步骤会丢失信息并可能导致伪影,使用滤波器用于增强重建视频质量,包括环路内滤波(预测下一图像前)和环路外滤波(输出前)。另外为了减少数据量,在压缩前会进行下采样,并在之后进行上采样。

- 帧内预测:用于预测同一图像内各块之间关系的工具

- 帧间预测:视频帧间预测的工具,旨在消除时间维度上的冗余,在传统视频编码方案中,帧间预测主要通过块级运动估计(Motion Estimation)和运动补偿(Motion Compensation)来实现

- 跨通道预测:在 YUV 中一般是按照顺序编码的,可以用 Y 预测 U,用 YU 预测 V

- 概率分布预测:基于熵编码对概率估计的依赖性,利用深度学习进行概率分布预测,提高熵编码的效率

- 变换:混合视频编码(hybrid video coding)中将信号(通常是 residues 残差)转换为系数而后进行量化及编码,一开始常用 DCT,而后转为 ICT

- 滤波:用于应对量化产生的伪影(visible artifact),通过减少伪影、提高重建图像/视频质量,从而间接提高压缩效率的工具

- 上下采样:在编码前将分辨率降低(包括空间分辨率,时间分辨率也就是帧率,像素分辨率也就是位深度),在解码后将视频分辨率恢复,深度工具中分为仅训练深度网络作为上采样滤波器和同时训练上采样滤波器和下采样滤波器以提供更大灵活性两种

- 编码优化:上述工具在保持 PSNR 的同时降低比特率,还有一类是仅用于编码器端的工具,包括快速编码、码率控制以及 ROI 编码

总结来看,现有的深度工具可分为三类:

- 旨在提高压缩效率,通常以增加编码/解码时间为代价(预测、变换、滤波、上下采样)

- 用于提升编码速度,通常以降低压缩效率为代价

- 码率控制和 ROI ,仍然需要验证

3.4 DLVC 案例分析

DVLC 是作者提出的一种编码框架,笔记主要关注于综述部分,因此跳过该部分

3.5 展望与结论

一些开放性问题:

- 深度学习方案:将深度学习方面的工具结合传统的编码方案,形成性能更优的“深化”编码方案

- 压缩效率与计算复杂度:深度工具的计算复杂度远远高于传统方案,开发新型高效紧凑的深度网络/采用专为深度网络设计的硬件

- 面向感知自然和语义质量的优化:传统非深度编码方案最常用的质量指标仍是 PSNR,语义与自然感知方面可以进一步探索,另外信号保真度、感知自然度与语义质量之间存在权衡关系,需要判别优化目标与实际需求的关系

- 特殊性与普适性:编码方案必须在一定程度上兼具特殊性和普遍性。对于深度方案和深度工具而言,这要求训练数据应当经过精心筛选,以反映目标数据域的特征

- 深度工具联合使用:由于多重编码工具的相互依赖性,大多单独设计的深度工具不可以很好的联合在一起使用

未来发展趋势:

- 需要处理新型数据(如深度图、点云、三维表面等)的技术

- 视频分辨率的升级

- 更高压缩效率、更低计算复杂度、更智能集成的视频分析系统

4 Advances in Video Compression System Using Deep Neural Network: A Review and Case Studies

该文献的作者包含马展老师

注意:该文献发表于 2021 年

本文仅对该文献综述模块进行总结

该文献主要聚焦总结了预处理、编码和后处理的方向,从传统方法入手并结合了深度神经网络。

4.1 模块简介

- 编码:将像素转成 bit 流,由于概率失真权衡(R-D Tradeoff)引发的压缩伪影

- 后处理:减轻视觉主要依靠指定的自适应滤波器来提升重建视频质量或体验质量

- 预处理:利用人类的视觉非线性感知,提升编码块的视觉性能

4.2 视频预处理

主要分成两类,预滤波和视频内容语义分析

- 显著性驱动预处理(Saliency-Based Preprocessing)

通过DNN预测视频中吸引人注意的区域(salient regions),并结合不等质量编码(Unequal Quality, UEQ),在显著区域采用轻压缩、非显著区域采用高压缩,从而在码率不变或更低的情况下提升感知质量。

- 分析/合成式预处理(Analysis/Synthesis-Based Preprocessing)

利用人类视觉系统的非线性响应与遮蔽效应,区分感知显著区域与感知不显著区域。通过CNN提取纹理特征,对不显著纹理采用统计建模或合成方式重建,可显著减少比特率而保持主观一致性。

4.3 视频编码

主要有三个方向,分辨率重采样(下采样并重建)、模块化神经视频编码、端到端神经视频编码

- 模块化神经视频编码(MOD-NVC)

在传统混合框架中替换或优化部分工具:帧内预测、帧间预测、量化与熵编码。其问题在于计算复杂度显著上升,需平衡传统算法与学习算法的融合

- 端到端神经视频编码(E2E-NVC)

以自编码器(AE/VAE)结构为核心,通过CNN/RNN堆叠直接学习视频的时空特征表示。主要模块包括:非线性变换与量化、运动建模、率失真优化、感知损失

4.4 视频后处理

后处理旨在去除压缩伪影(方块、振铃、油画化等),分为:

环路内滤波:如 VRCNN、IFCNN 等轻量网络,平均 5%–8% BD-Rate 节省;更深网络可达 10% 以上但复杂度高;

解码端后滤:针对多帧时序一致性问题,引入基于光流的帧对齐与多帧增强。

这类DNN后处理在主观与客观指标上均明显优于传统SAO或CDEF滤波器,成为视频增强的重要方向

通过这个来实现。快捷键为 ctrl + U

评论已关闭